フィナンシャル・モデリング・チャレンジとは、AI(機械学習)を使って金融モデル(というよりも投資モデル)を作り、そのモデルの精度を競うコンペティションです。

例えば、ヘッジファンド大手のツー・シグマはKaggleを通じてこのようなコンペティションを開催しています。

また、最近では海外大手ヘッジファンドX(こういう名前のヘッジファンドではなく、名前を伏せてXと呼んでいる)がDeepAnalyticsを通じてコンペティションを開催しています。

その他にもNumeraiやQuantopianなど、参加者の作ったモデルを利用して運用するファンドも存在します。

では、このようなチャレンジで上位に入るモデルを使うと、実際の運用で利益を出すことが可能なのでしょうか??

1.リーダーボード

このようなコンペティションでは、リーダーボードが使われます。

リーダーボードとは、各参加者のモデルを何らかの指標に基づいてランク付けしたものです。

評価するための指標にはLOGLOSS(対数損失関数)が使われることが多いようです。

リーダーボードには、パブリックとプライベートの2種類があります。

(1)パブリックリーダーボード

コンペティション開催期間中に、各参加者が自分の位置付けがおおよそどのくらいかを把握するためのものです。

オーバーフィッティングの影響を排除するため、訓練データには含まれないデータを使うことが一般的です。

(2)プライベートリーダーボード

最終的なコンペティションの順位を決めるためのボードです。

各参加者はコンペティションが終了するまでこれを閲覧することはできません。

こちらもオーバーフィッティングの影響を排除するため、訓練データおよびパブリックリーダーボードデータには含まれないデータが用いられます。

2.どのようなモデルが上位に入るか

では、このようなコンペティションで上位に入るモデルとはどのようなモデルでしょうか?

当然ですが、上位に入るモデルはプライベートリーダーボード用のデータで高いLOGLOSSを達成したものになります。

「高いLOGLOSS」とは「高い勝率(的中率)」とほぼ同義です。

(1)コンペティションのあるべき姿

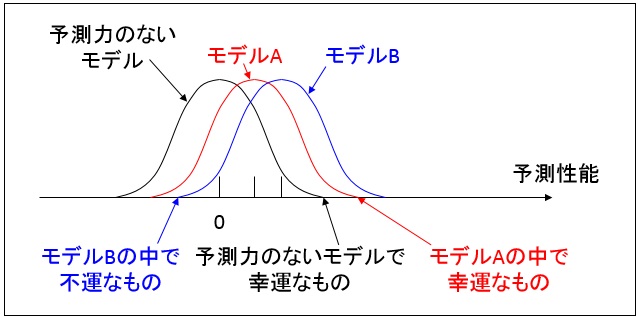

プライベートリーダーボードで観察されるモデルの予測性能とは、そのモデルの持つ真の予測性能にランダムネスを足し合わせたものになります。

これを確率分布で示すと、以下の図のようになります。

この場合、単純に観察された予測性能に従って判定すれば、最も良いモデルが優勝することになります。

図1.理想的なコンペティションの確率分布

(2)フィナンシャル・モデリング・チャレンジの実情

ところがフィナンシャル・モデリング・チャレンジでは、上記のような確率分布にはならず、以下のようなものとなります。

この理由として、フィナンシャルデータは画像認識などと比べて遥かに予測が難しく参加者同士の予測性能に差が付きにくいこと、フィナンシャルデータは過分散であり予測性能のバラツキが大きくなることが挙げられます。

図2.フィナンシャル・モデリング・チャレンジにおける確率分布

(3)どのようなモデルが上位に入るか

上記から分かるように、フィナンシャル・モデリング・チャレンジのランク付けは「実力」と「運」の双方によって決まることになるのですが、「運」の要素が比較的大きな割合を占めるように思います。

参加者の作るモデルの真の予測性能はおおよそ52%~53%程度であり、それほど大きな差が付くものではありません。

その中から、ランダムネスの恩恵を受けることのできた運の良いモデルが上位に入るのです。

3.フィナンシャル・モデリング・チャレンジのパラドックス

主催者は上位に入ったモデルの予測性能が、本来備えている真の予測性能なのかランダムネスの産物なのか切り分けることはできません。

もしもコンペティションのモデルで実運用しようと考えた場合、主催者はどのようにモデルを選べばよいのでしょうか?

結局のところ、主催者は上位に入ったモデルを選ぶしかないのです。

そのほうが確率分布的に考えたときに、他のモデルよりも優れている可能性がわずかばかり高いからです。

しかし、そのモデルを運用したときのパフォーマンスはコンペティションのものよりも必ず劣化してしまいます。

なぜなら、コンペティションでの成績は「運」により水増しされているのですから。

このように主催者は、「上位のモデルを選ぶしかないが、それを選ぶと必ずパフォーマンスが劣化する(場合によっては損失を出す)」ことになります。

これをフィナンシャル・モデリング・チャレンジのパラドックスと(勝手に)呼びます。

4.実際のデータを見てみよう

上記を裏付けるデータは、なかなか取得することができません。

ここでは、フィナンシャル・モデリング・チャレンジが如何に難しいかを指し示すデータを準備しました。

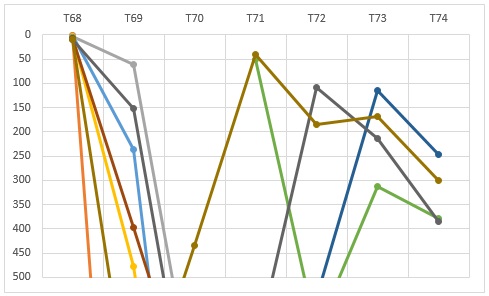

投資モデルのコンペティション(トーナメント)を毎週行っているNumeraiのデータを見てみます。

公開されている直近の7トーナメント(T68~T74)の結果から、最も古いT68でトップ10に入った参加者のその後の順位の推移を観察します。

図3.Numeraiトーナメント68トップ10のその後の順位推移

このように、トップ10に返り咲くことは至難の業となっています。

もしも、トーナメントの順位が参加者の実力だけで決定されるのだとすれば、このような事態が起こりうるのでしょうか?

5.まとめ

フィナンシャル・モデリング・チャレンジで上位に入った参加者は、「実力」と「運」を兼ね備えたツワモノです。

しかしそのモデルを実際に運用するときにも引き続き「運」が味方するとは限りません。

もしもこのようなコンペティションで上位を狙う場合、モデルの作り方として汎化性能を高めたものでなく、少し偏向させたモデルを作るほうがよいかもしれません。

そのほうが、万が一「運」が味方したとき他者に対して伸び代が大きくなるからです。

直近の日経平均は稀にみる連騰ですが、この期間では何も考えず「買い」だけを予測したモデルが最も利益を得るはずです。

フィナンシャル・モデリング・チャレンジでも同様のことだと思います。

コンペティション主催者は、懸賞金を掛けて探し出した宝箱を開けてみると中身が空だった、ということが無ければよいのですが。